🧠 네트워크 코어 (Network Core)

- 네트워크의 중심: 전 세계 ISP들이 연결된 고속 백본망

- 구성 요소: 라우터(Router) 로 구성된 Mesh Network

- Access Network 들이 코어 네트워크에 연결되어 전체 인터넷을 형성

🔀 패킷 스위칭 (Packet Switching)

- Application Layer의 데이터는 작은 패킷들로 분할됨

- 각 패킷은 독립적으로 전달되고, 목적지에서 다시 조립됨

- 공유 자원 개념 → 하나의 링크를 여러 통신이 공유 가능

🔁 Store-and-Forward 방식

- 라우터는 전체 패킷을 수신한 후에 다음 홉으로 전달

- 예: 버스가 승객 5명 모두 탈 때까지 출발하지 않는 방식

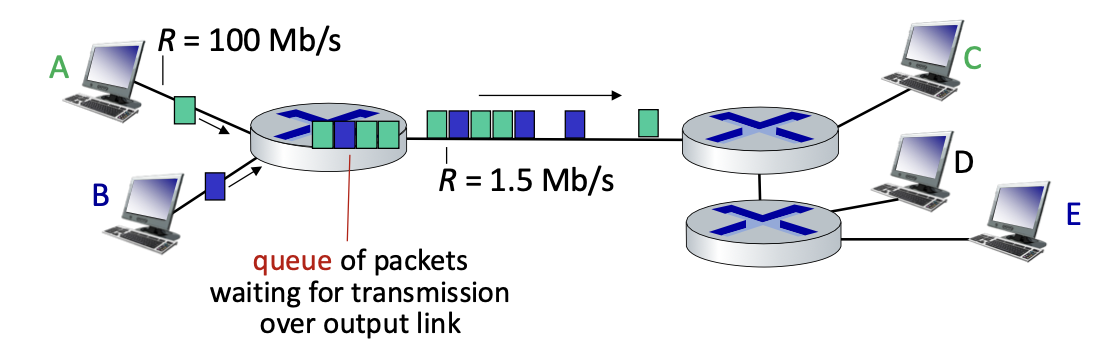

⏱ 전송 지연 vs 큐잉 지연

전송 지연 (Transmission Delay)

- 패킷을 링크에 밀어넣는 데 걸리는 시간

- L / R (L: 패킷 길이, R: 링크 전송 속도)

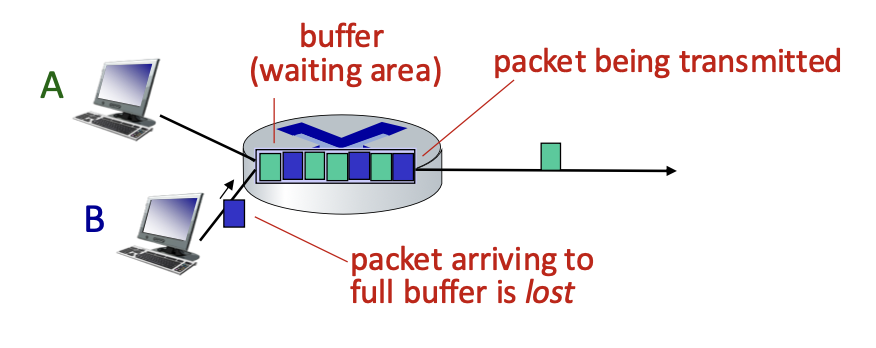

큐잉 지연 (Queueing Delay)

- 라우터가 바쁜 경우, 패킷이 줄 서서 대기

- 큐가 길수록 지연 증가

- 큐 용량 초과 시 → 패킷 손실 발생

패킷 손실 (Packet Loss)

- 큐가 꽉 차서 버퍼 오버플로우 발생

- 도착한 패킷을 버릴 수밖에 없음

- 결과적으로 데이터 유실 발생

→ TCP는 재전송을 통해 복구하려 하지만, 지연은 증가

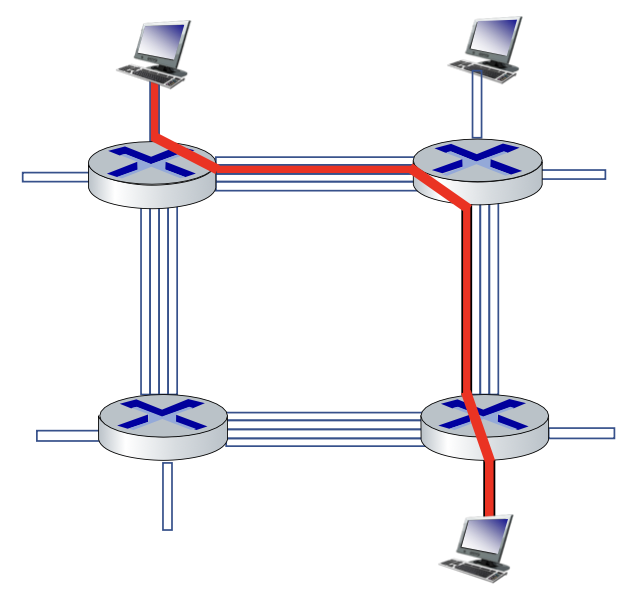

📦 포워딩(Forwarding)과 라우팅(Routing)

코어 네트워크의 핵심적인 두 기능에는 포워딩(스위칭), 라우팅이 있다.

포워딩 (Forwarding)

- 라우터 내부에서 패킷을 입력 → 출력 포트로 전달하는 작업

- 각 라우터는 포워딩 테이블을 사용하여 다음 홉 결정

라우팅 (Routing)

- 전체 네트워크 경로를 결정하는 알고리즘

- 예: RIP, OSPF, BGP 등

포워딩 테이블과 헤더

- 각 라우터는 로컬 포워딩 테이블을 가짐

- 패킷의 헤더(header) 에 목적지 주소가 들어 있음

- 라우터는 이 주소를 참조하여 다음 홉을 선택

헤더란?

- 원본 데이터가 아님

- 제어 정보(Control Information) 를 포함한 필드

- 필수 정보지만 오버헤드(Overhead) 로 간주됨

포워딩 테이블 구조

| 192.168.0.0/16 | 포트 1 |

| 10.0.0.0/8 | 포트 2 |

| ... | ... |

- 이 테이블은 라우팅 알고리즘에 의해 자동 갱신됨

- 각 라우터는 전 세계 라우팅 프로토콜을 통해 정보를 수신하고 테이블을 유지

📦 네트워크 스위칭 방식

스위칭이란?

- 데이터 네트워크는 목적지까지의 경로를 찾기 위해 스위칭 필요

- 두 가지 방식

- 회선 교환 (Circuit Switching)

- 패킷 스위칭 (Packet Switching)

🔁 회선 교환 (Circuit Switching)

- 자원(링크 용량, 대역폭 등)을 송신자-수신자 사이에 전용으로 할당

- "예약(reserved)"과 "할당(allocated)" 개념 강조

- 전용 회선은 다른 사용자와 공유 불가 → 독점 사용

✅ 특징

- Guaranteed Performance (보장된 성능)

- 음성 통신(전화)의 전통적 방식

- 통화 설정(Call Setup) 필요: 전화 걸기 → 연결음 → 수신자 응답 → 통화 시작

❌ 단점

- 설정 시간 필요 (5초 이상)

- 자원 낭비 가능 (대기 중에도 링크 전용)

- 통화 중 일시 정지 시간(idle time)도 자원은 계속 점유

- 동시 통화 수 제한됨 → 통화 실패(Busy signal) 가능

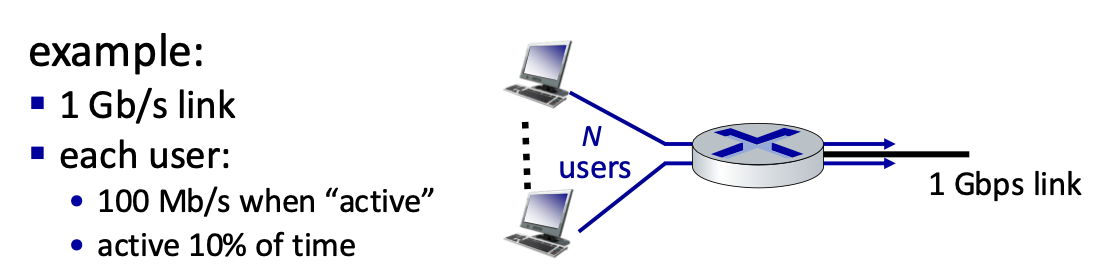

📧 패킷 스위칭 (Packet Switching)

- 데이터를 작은 패킷으로 나눠 전송

- 각 패킷은 경로를 공유하며 독립적으로 전송됨

✅ 장점

- 자원 공유 가능 → 네트워크 활용률 높음

- 통화 설정 과정 불필요

- Bursty 데이터에 적합 (이메일, 웹 브라우징 등)

- 네트워크 사용량에 따라 유동적으로 처리

❌ 단점

- 혼잡 시 지연 증가

- 패킷 손실 가능 (버퍼 오버플로우)

- QoS 보장이 어려움 → 추가적인 프로토콜 필요

🔁 회선처럼 동작하게 만들 수 있을까?

회선처럼 작동하는 패킷 스위칭?

- 음성/영상처럼 실시간 성능(QoS)이 필요한 경우 회선 교환이 더 유리

- 하지만 패킷 스위칭에서도 QoS 보장을 위한 기술이 존재

해결 방식

- 예약 기반 프로토콜 사용 → 자원 예약 (예: RSVP)

- 비용 증가: 다른 사용자 접근 제한하므로 비싸짐

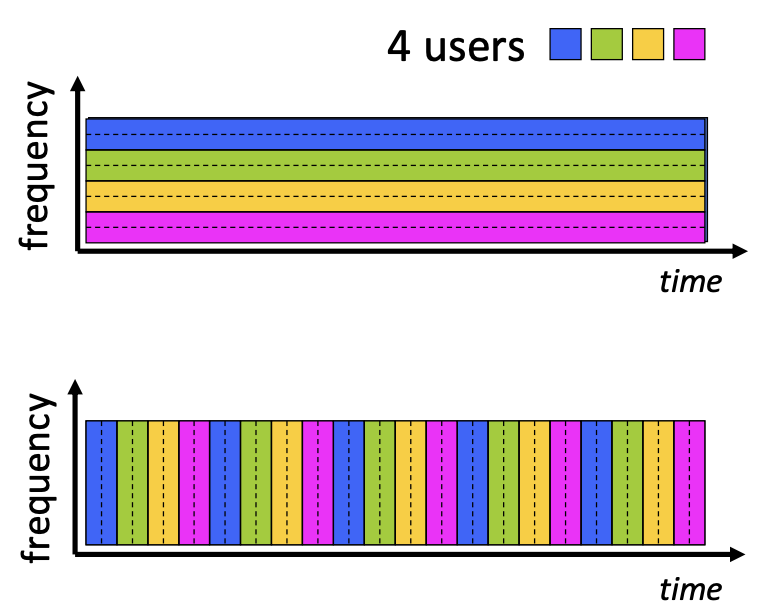

Multiplexing (다중화)

- 제한된 링크를 여러 사용자가 나눠서 사용

| FDM (Frequency Division Multiplexing) | 주파수 대역을 나눔. 예: 버스 전용 차선, 1차선, 2차선 등 |

| TDM (Time Division Multiplexing) | 시간 슬롯을 나눔. 예: 라운드 로빈 방식처럼 시간 분할 |

💡 성능 비교: 회선 vs 패킷

| 자원 | 전용 | 공유 |

| 효율성 | 낮음 | 높음 |

| 설정 시간 | 필요 | 없음 |

| 사용자 수 | 제한적 | 유연 |

| 지연 | 일정 | 가변 |

| QoS 보장 | 쉬움 | 어려움 (보완 필요) |

실제 인터넷에서는 패킷 스위칭이 압도적으로 우세 예외적으로 음성/영상 같은 실시간 애플리케이션은 QoS 보장이 중요

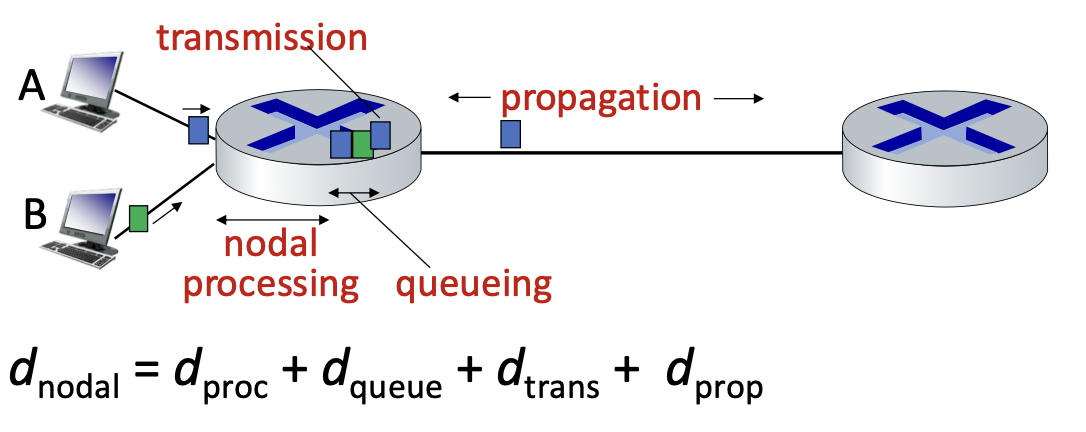

🕐 네트워크 지연 요소 (Delay in Networks)

Nodal Delay (노드 지연)

패킷이 한 라우터에서 다음 라우터로 이동할 때 발생하는 총 지연

| Processing Delay | 헤더 확인, 에러 체크, 라우팅 결정 등 |

| Queuing Delay | 출력 링크를 기다리는 대기 시간 |

| Transmission Delay | 패킷을 링크에 밀어 넣는 시간 (L/R) |

| Propagation Delay | 신호가 링크를 따라 전파되는 시간 (d/s) |

→ nodal delay(총 지연) = Processing + Queuing + Transmission + Propagation

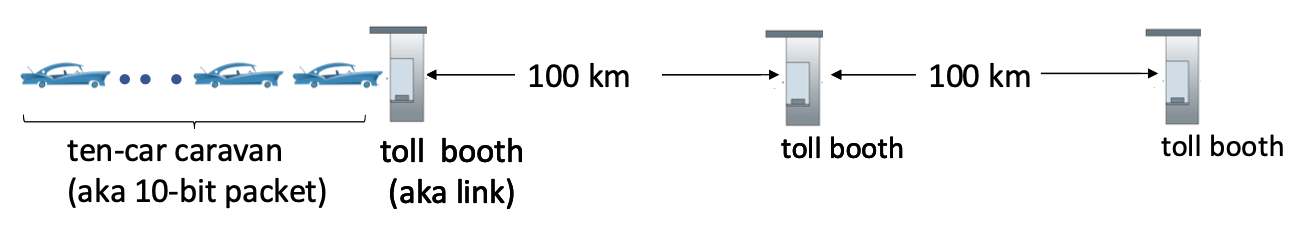

캐러밴(Caravan) 비유

- 자동차(Car) = 비트(Bit)

- 톨게이트(Toll Booth) = 라우터

- 고속도로 = 링크

예시:

- 톨게이트 처리: 차당 12초

- 10대 차 통과 = 120초 (Transmission delay)

- 거리: 100km, 속도: 100km/h → Propagation: 1시간

- 총 지연 = 120초 + 3600초 = 62분

✅ **전송 지연(Transmission)**과 전파 지연(Propagation) 은 별개의 개념

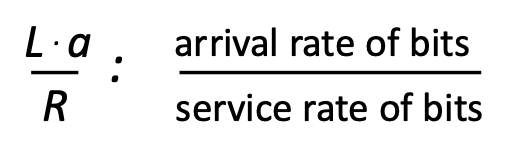

🚦큐잉과 혼잡 (Queuing and Congestion)

Traffic Intensity (트래픽 강도)

네트워크에서 트래픽 강도(Traffic Intensity)는 다음 수식으로 정의된다:

트래픽 강도 = (패킷 도착률 × 패킷 길이) / 링크 전송률 = La / R

- L: 패킷 길이 (bits)

- a: 평균 패킷 도착률 (packets/sec)

- R: 링크 전송률 또는 대역폭 (bits/sec)

이 수치는 네트워크의 혼잡 상태를 정량적으로 표현해준다.

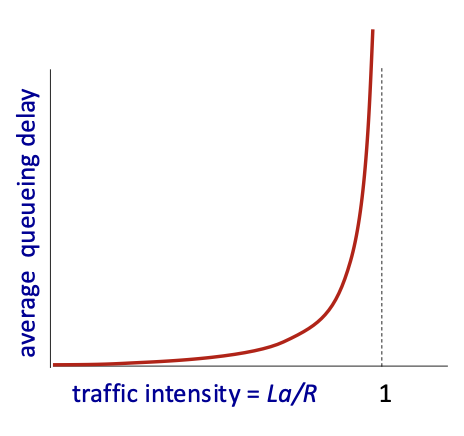

트래픽 강도에 따른 큐잉 지연 변화

- La/R ≈ 0이면 → 평균 큐잉 지연이 매우 작음 (거의 없음)

- La/R → 1이면 → 큐잉 지연이 지수적으로 증가

- La/R > 1이면 → 처리 가능한 양보다 많은 트래픽이 유입됨 → 큐가 넘치며 지연이 무한대에 수렴 → 결국 혼잡 폭발(Congestion Collapse) 발생 가능

혼잡 상태에서의 지연 그래프

트래픽이 증가하면 처음에는 지연이 완만하게 증가하지만,

트래픽 강도가 1에 가까워질수록 지연이 급격히(지수적으로) 증가한다.

이때 큐에 대기 중인 패킷들이 많아지며, 처리 속도를 초과하는 순간

지연은 무한대로 발산하게 된다.

→ 이는 네트워크 성능을 심각하게 저하시킬 수 있으며,

혼잡 제어(Congestion Control)가 필수적인 이유이기도 하다.

패킷 손실 (Packet Loss)

- 큐(버퍼)가 꽉 차면 새로 들어오는 패킷은 버려짐(drop)

- TCP에서는 재전송을 통해 복구 가능하지만, 지연은 증가

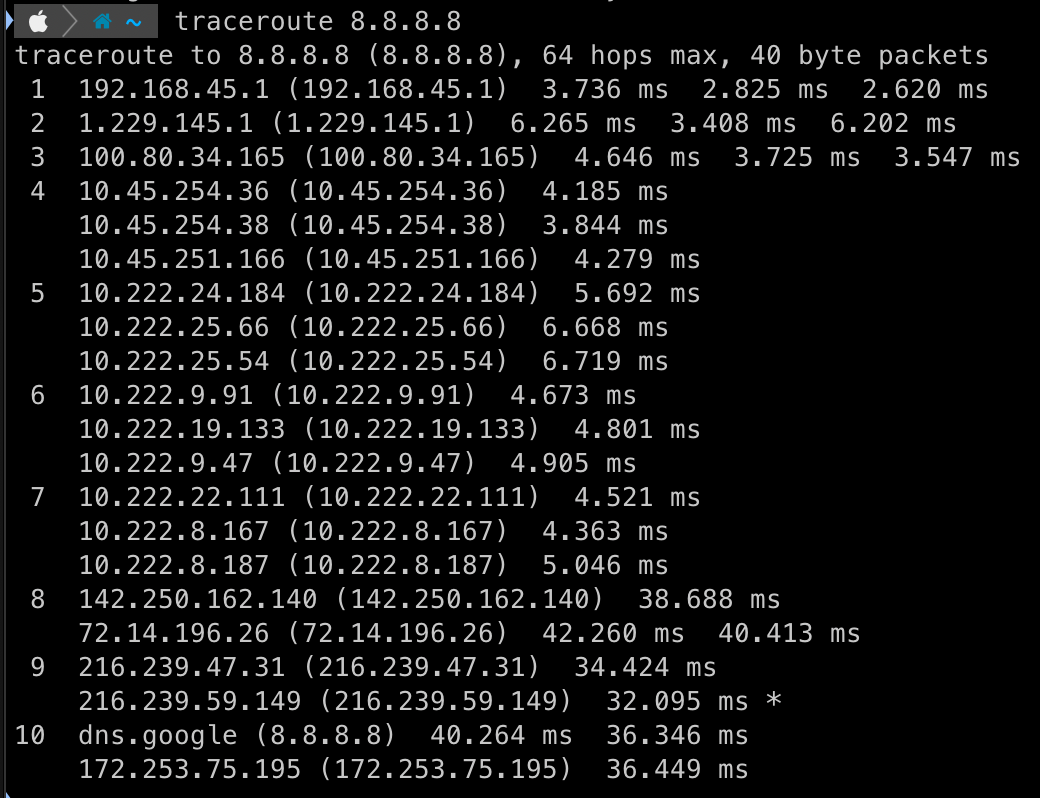

TraceRoute 실습 예시

TraceRoute란?

- 목적지까지 경유하는 라우터 목록과 각 지연 시간(ms) 을 확인

출력 예시

- 각 홉(hop) 을 따라 측정

- 병목 구간(bottleneck)을 시각적으로 파악 가능

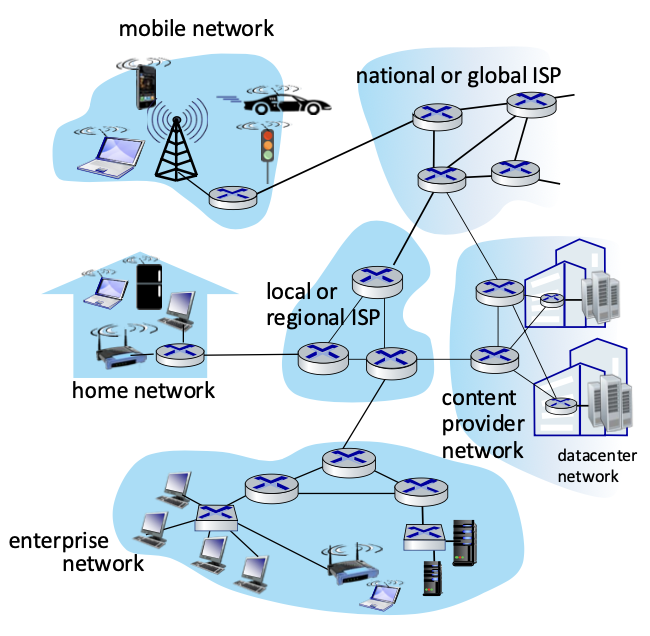

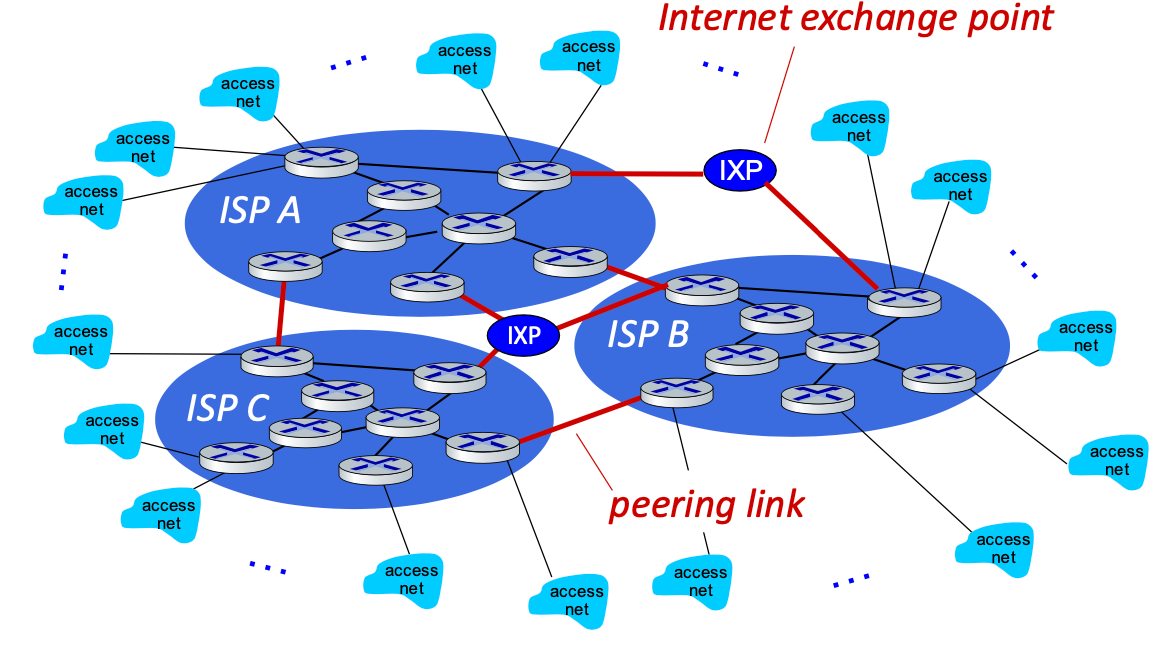

🏗️ 인터넷 아키텍처: 네트워크의 네트워크

인터넷은 수많은 네트워크가 서로 연결되어 구성된 거대한 시스템이다. 그런데 이 방대한 구조 속에서도 중심 역할을 하는 소수의 대형 네트워크들이 존재한다. 이들은 인터넷의 백본(Backbone)이라고 할 수 있을 만큼 중요한 위치를 차지하고 있다.

중심에 위치한 대형 네트워크들

인터넷의 중심에는 소수의 잘 연결된 대형 네트워크들이 존재한다. 이 네트워크들은 전 세계적으로 광범위하게 커버리지를 갖고 있으며, 다른 수많은 네트워크의 트래픽을 중간에서 중계하는 역할을 한다.

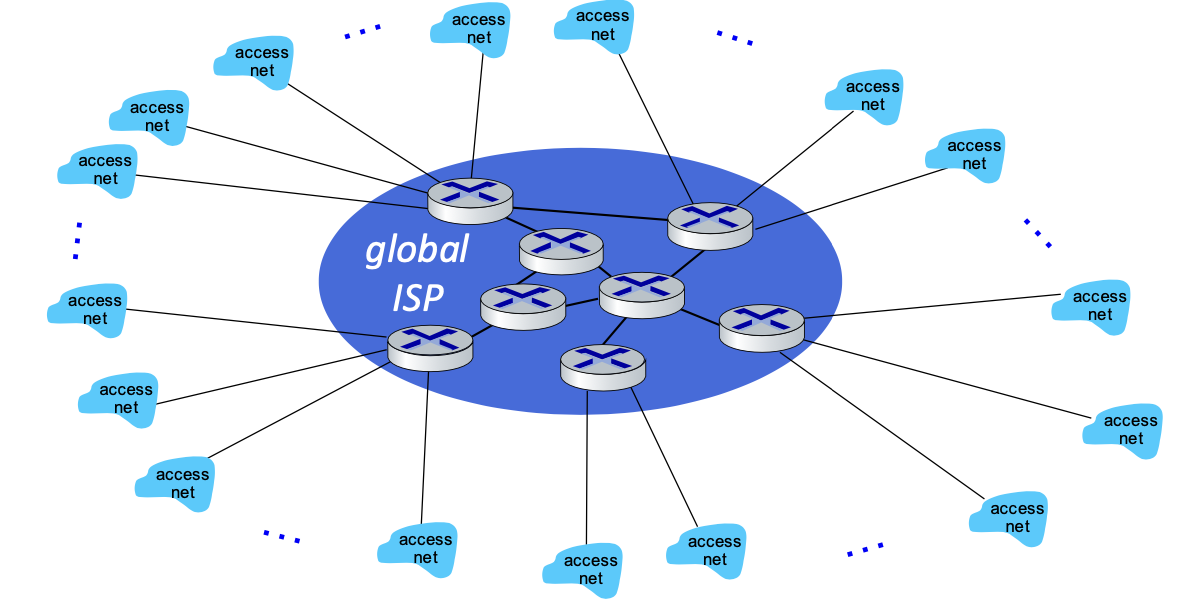

1. 글로벌 ISP : Tier-1 상업용 ISP

이들 중심 네트워크 중 대표적인 예가 “Tier-1” 상업용 ISP(Internet Service Provider)들이다. 예를 들면 다음과 같은 기업들이 있다:

• Level 3

• Sprint

• AT&T

• NTT

이들은 국가 및 국제적인 규모의 커버리지를 제공하며, 서로 직접 연결되어 있다. Tier-1 ISP들 사이에서는 일반적으로 트래픽 교환을 위해 비용을 지불하지 않으며, 이러한 상호 연결을 피어링(peering)이라고 부른다.

2. 경쟁 ISP : Tier-2 상업용 ISP

어떤 하나의 글로벌 ISP가 전 세계 인터넷을 독점할 순 없으므로 여러 하위 ISP들이 서로 경쟁 관계에 놓이게 되고, 그러면서도 연결(커넥티비티)은 유지되어야 한다.

한국에서는 KT (ISP A), SK브로드밴드 (ISP B), LG유플러스 (ISP C)등이 있다.

서로 다른 ISP들 간에 트래픽을 교환해야 하는데, 그 방식 중 하나가 바로 인터넷 교환 지점(IXP)이다.

IXP (Internet Exchange Point)의 역할

IXP는 여러 ISP나 네트워크 사업자들이 모여 트래픽을 직접 교환(peering)할 수 있는 물리적인 장소이자 시스템이다.

IXP를 통해 데이터가 중간의 제3자(ISP)를 거치지 않고 바로 전달되기 때문에 아래 장점이 있다.

- 비용 절감

- 지연 시간 감소

- 대역폭 효율 향상

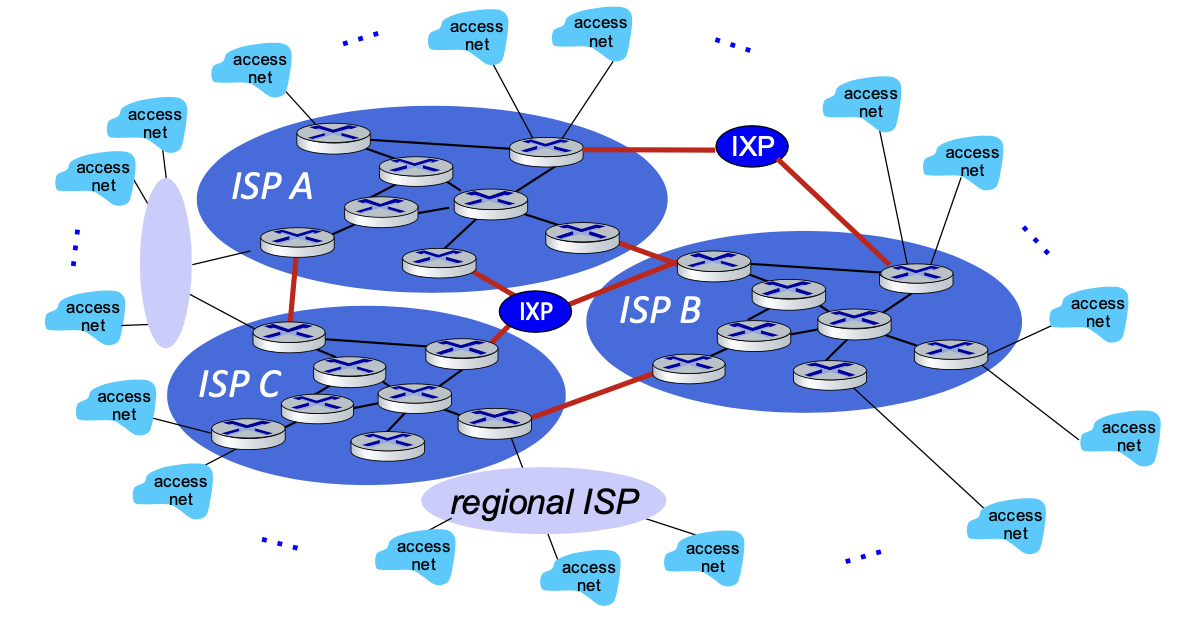

3. 지역 ISP : Tier-3 상업용 ISP

지역 ISP는 일반 가정이나 소규모 기업에 직접 인터넷 접속 서비스를 제공하는 사업자다. 우리가 집에서 사용하는 유선 인터넷이나 와이파이 연결은 대부분 이 Tier-3 ISP를 통해 이루어진다.

특징

• 최종 사용자에게 인터넷을 직접 제공

• 자체 글로벌 네트워크는 없고, 상위 ISP(Tier-2, Tier-1)에 연결되어 인터넷에 접근

• 지역 기반으로 운영되며, 서비스 범위가 한정적일 수 있음

예시

• 대도시 외곽이나 시골 지역에서 운영되는 소규모 케이블 인터넷 업체

• 한국에서는 대부분 KT, SKB, LGU+와 같은 대형 통신사의 하위 유통망 또는 협력사 형태로 존재

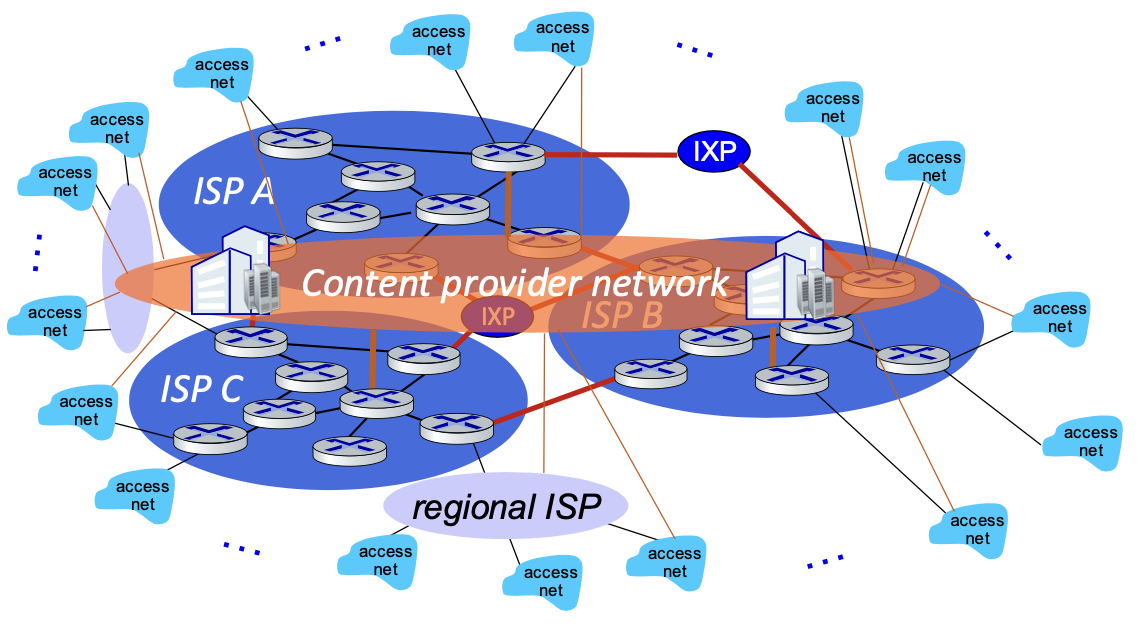

4. 콘텐츠 제공자 네트워크 (Content Provider Networks)

최근에는 또 다른 강력한 주체들이 등장했다. 바로 Google, Facebook과 같은 대형 콘텐츠 제공자(Content Provider)들이다.

이들 기업은 단순히 서비스를 제공하는 것에 그치지 않고, 자체적인 사설 네트워크(백본)를 구축해 전 세계 데이터 센터들을 직접 연결하고 있다. 이 네트워크는 경우에 따라 Tier-1 ISP나 지역 ISP를 우회하면서, 더욱 빠르고 안정적인 데이터 전송을 가능하게 한다.

즉, 콘텐츠 제공자 네트워크는 다음과 같은 특징을 가진다:

• 자체 사설 백본을 보유하고 있음

• 사용자에게 가까운 위치의 데이터 센터에서 콘텐츠를 제공

• Tier-1이나 지역 ISP를 거치지 않고 직접 연결을 시도

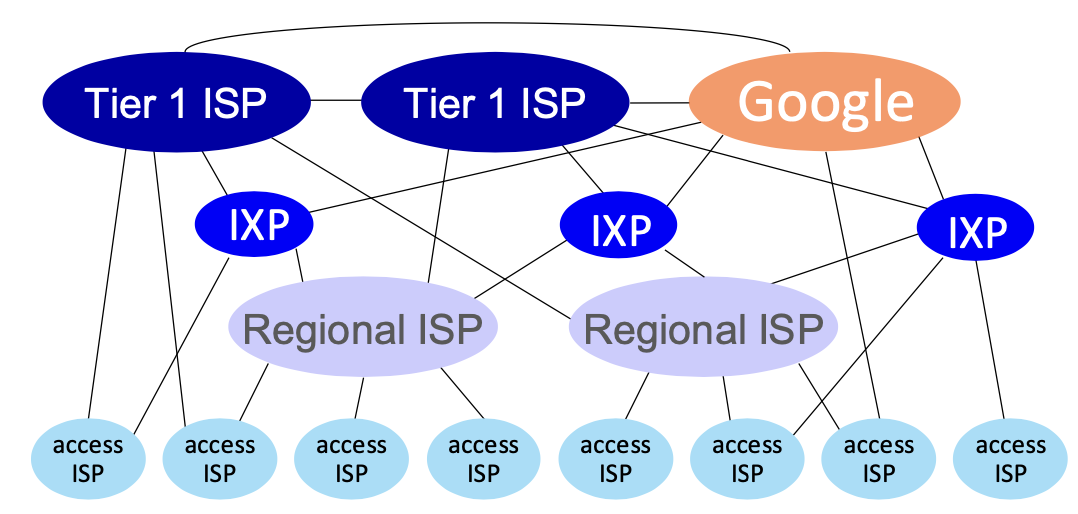

전체 네트워크 아키텍처

| Tier-1 ISP | 국제적 ISP (AT&T, Sprint, NTT 등) |

| Tier-2 ISP | 국가/지역 규모 ISP (KT, SKT 등) |

| Tier-3 ISP | 소규모 지역망, 기업/학교 등 |

인터넷은 다수의 ISP와 연결된 거대한 메쉬 네트워크

접속 방식

- Peering: 동등한 ISP 간 무료 상호 연결

- Transit: 하위 ISP가 상위 ISP에 요금 지불

📦 콘텐츠 제공자 네트워크 (CDN: Content Delivery Network)

개념

- Netflix, Google, Naver, Kakao 등은 자체 네트워크는 없지만, 콘텐츠를 제공

- ISP 인프라를 이용해서 서비스함

문제와 충돌(망사용료)

- ISP: “트래픽 유발하니 비용 내라”

- 콘텐츠 제공자: “사용자는 이미 요금 지불했다”

해결책: CDN

- 전 세계에 데이터 센터/서버 배치

- 사용자가 가까운 서버에서 콘텐츠를 받음 → 지연 감소

주요 CDN 기업

- Akamai: 글로벌 최대 규모 CDN

- Netflix: 자체 CDN 보유

- 국내 방송사들도 CDN 업체와 제휴

POP (Point of Presence)

- ISP/콘텐츠 사업자가 서버/라우터를 물리적으로 설치한 지점

- 예: 서울 강남 POP, 대전 POP, 부산 POP 등

- 각 지역의 핵심 허브

| 회선 교환 | 예약된 자원, 안정적 QoS, 저효율 |

| 패킷 스위칭 | 자원 공유, 고효율, 지연 및 손실 가능성 |

| Multiplexing | 주파수 or 시간 분할을 통해 자원 공유 |

| 지연 요소 | 처리, 큐잉, 전송, 전파 |

| TraceRoute | 실제 경로와 지연 추적 가능 |

| CDN | 콘텐츠 접근성 개선, ISP와 이해관계 있음 |

| POP | 네트워크 허브, 물리적 설치 위치 |

Throughput

네트워크에서 데이터를 전송할 때, 우리가 가장 중요하게 생각하는 개념 중 하나는 바로 throughput (처리량) 이다.

비트/시간 (Bits per Time)

- Throughput은 단순히 말해 단위 시간당 전송된 비트 수이다.

- 단위는 bps (bits per second)이며, 이는 "bits/time"이라고도 표현한다.

- 송신자가 수신자에게 비트를 전송하는 속도를 의미한다.

순간 전송률 (Instantaneous Rate)

- 어떤 특정 시점에서의 전송 속도를 말한다.

- 예를 들어 지금 이 순간에 몇 bps로 데이터가 흘러가고 있는지를 측정하는 것.

- 이는 실시간적인 개념이며, 매우 짧은 시간 구간에서 측정한다.

평균 전송률 (Average Rate)

- 여러 순간 전송률들을 일정 시간 동안 평균 낸 값이다.

- 즉, 여러 순간적인 속도를 합쳐서 전송 전체의 평균 속도를 구하는 것.

- "rates over a longer period"이며, 이것이 실제 말하는 throughput이라는 개념이다.

- "So we pick some point in time and then we average those instantaneous rates. It becomes an average rate."

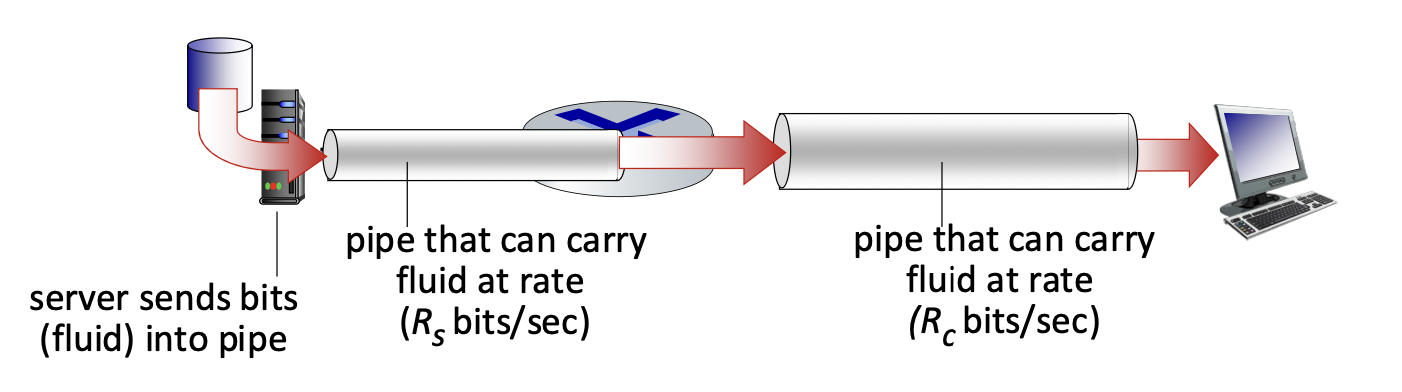

파이프와 유체의 비유

- 송신자는 유체를 흘려보내는 입구이고,수신자는 그 유체를 받아들이는 출구이다.

- 각각의 파이프는 데이터(유체)를 Rs bps, Rc bps로 처리할 수 있다고 가정한다.

- 파이프가 두껍다는 것은 그만큼 처리 가능한 비트의 양이 크다는 의미다.

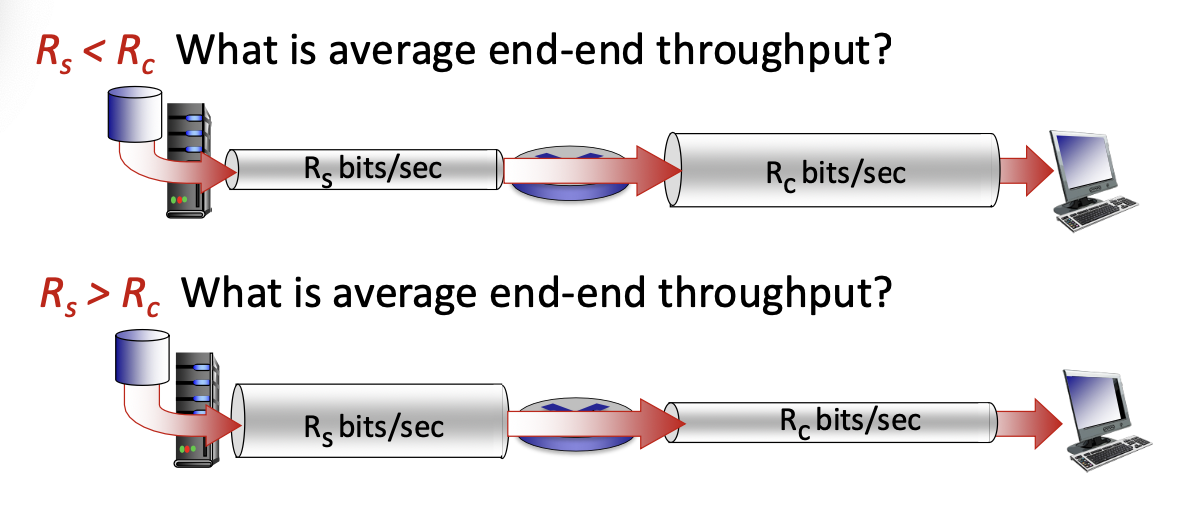

병목 상황

- 만약 송신자의 처리 속도(Rs)가 수신자(Rc)보다 느리면, 송신자가 병목이 된다.

- 반대로, 수신자가 더 느리면, 수신자가 병목이다.

- 전체 시스템의 평균 end-to-end throughput은 항상 가장 낮은 처리 속도에 의해 제한된다.

Bottleneck Link (병목 링크)

- 실제 네트워크에서는 전체 경로 중 가장 대역폭이 낮은 링크가 전체 처리량을 제한한다.

- 이 링크를 병목 링크 (bottleneck link)라고 부르며, 이는 available bandwidth가 가장 좁은 구간이다.

- "A bottleneck link is a link along an end-to-end path that constrains the end-to-end throughput."

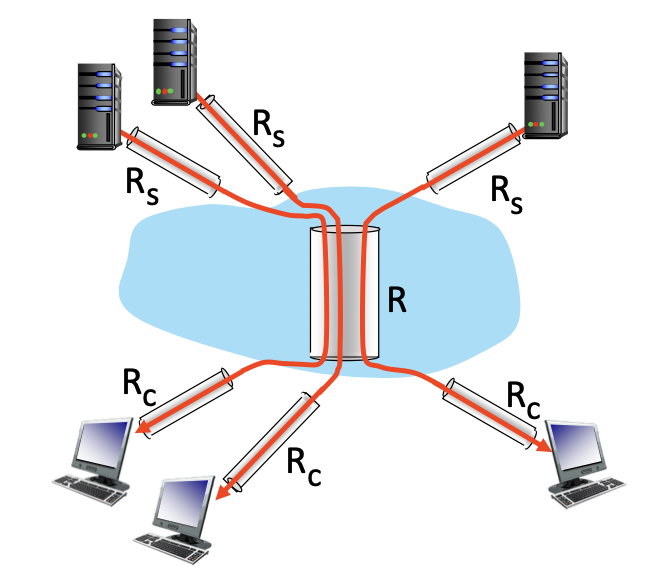

네트워크 시나리오에서의 처리량 계산

- 전체 시나리오에서 10개의 호스트가 하나의 링크를 공유한다고 가정하자.

- 각 호스트는 공평하게 그 링크의 용량을 나눠 가지게 된다.

- 이 때, 각 연결당 처리량은 다음 중 가장 작은 값으로 결정된다: per-connection throughput = min(R/10, Rs, Rc)

- 즉, 공유 링크 용량을 10으로 나눈 값과 송수신 측 링크 용량 중 최솟값이 전체 처리량을 결정한다.

- "It's one of the thick minimums. That is the end-to-end throughput."

예를 들어, 10개의 호스트가 하나의 공유 링크를 통해 통신한다면, 전체 링크 용량 R은 공평하게 10개 호스트가 나누어 가지게 된다. 이때 한 연결당 처리량은 다음 세 가지 중 가장 작은 값으로 결정된다:

- R/10 (공유 링크를 나눈 값)

- 송신 측 링크 용량 (Rs)

- 수신 측 링크 용량 (Rc)

따라서 처리량은 다음과 같이 표현된다:

throughput = min(R/10, Rs, Rc)

실제 병목은 어디서 발생할까?

- 보통은 코어 네트워크(백본)가 병목이 아닐 수 있다.

- 이유는 ISP들이 충분한 용량으로 백본을 설계하기 때문.

- 병목은 오히려 **엣지 네트워크 (접속망)**에서 자주 발생함.

- 학교, 가정, 기업 등의 접속 구간이 좁은 대역폭을 가질 수 있다.

- Throughput은 단순한 속도가 아니라, 실제 전송 가능한 평균 비트 처리량이다.

- 순간 전송률의 평균으로 계산되고, 병목 구간에 의해 제한된다.

- 네트워크를 이해할 때 단순히 빠른 링크만 보는 것이 아니라, 전체 경로 중 가장 느린 구간을 파악하는 것이 중요하다.

코어 네트워크, 즉 백본 네트워크는 일반적으로 높은 용량을 가지므로 병목이 되는 경우가 드물다. 인터넷 서비스 제공자(ISP)들은 수익을 위해 백본 네트워크에 충분한 인프라를 구축해 두기 때문이다. 실제로 병목 현상은 학교, 가정, 소규모 기업 등에서 접속하는 엣지 네트워크(접속망)에서 더 자주 발생한다.

'CS 지식 > 네트워크' 카테고리의 다른 글

| [네트워크] 응용계층과 프로토콜, P2P, 클라이언트-서버 아키텍처 (0) | 2025.04.01 |

|---|---|

| [네트워크] 네트워크 계층 구조와 보안 입문 (0) | 2025.03.25 |

| [네트워크] 인터넷의 구조와 네트워크의 종류와 발전과정 (1) | 2025.03.23 |

| [네트워크 입문] 가상화 개념과 종류 (0) | 2025.02.05 |

| [네트워크 입문] 무선 LAN(WLAN)의 개념과 구조, 특징 (1) | 2025.02.05 |

댓글